English | 简体中文 | 繁體中文 | 한국어 | Español | 日本語 | हिन्दी | Русский | Рortuguês | తెలుగు | Français | Deutsch | Tiếng Việt |

🤗 Transformers aporta miles de modelos preentrenados para realizar tareas en diferentes modalidades como texto, visión, y audio.

Estos modelos pueden ser aplicados en:

- 📝 Texto, para tareas como clasificación de texto, extracción de información, responder preguntas, resumir, traducir, generación de texto, en más de 100 idiomas.

- 🖼️ Imágenes, para tareas como clasificación de imágenes, detección the objetos, y segmentación.

- 🗣️ Audio, para tareas como reconocimiento de voz y clasificación de audio.

Los modelos de Transformer también pueden realizar tareas en muchas modalidades combinadas, como responder preguntas, reconocimiento de carácteres ópticos,extracción de información de documentos escaneados, clasificación de video, y respuesta de preguntas visuales.

🤗 Transformers aporta APIs para descargar rápidamente y usar estos modelos preentrenados en un texto dado, afinarlos en tus propios sets de datos y compartirlos con la comunidad en nuestro centro de modelos. Al mismo tiempo, cada módulo de Python que define una arquitectura es completamente independiente y se puede modificar para permitir experimentos de investigación rápidos.

🤗 Transformers está respaldado por las tres bibliotecas de deep learning más populares — Jax, PyTorch y TensorFlow — con una perfecta integración entre ellos. Es sencillo entrenar sus modelos con uno antes de cargarlos para la inferencia con el otro.

Puedes probar la mayoría de nuestros modelos directamente en sus páginas desde el centro de modelos. También ofrecemos alojamiento de modelos privados, control de versiones y una API de inferencia para modelos públicos y privados.

Aquí hay algunos ejemplos:

En procesamiento del lenguaje natural:

- Terminación de palabras enmascaradas con BERT

- Reconocimiento del nombre de la entidad con Electra

- Generación de texto con GPT-2

- Inferencia del lenguaje natural con RoBERTa

- Resumen con BART

- Responder a preguntas con DistilBERT

- Traducción con T5

En visión de ordenador:

- Clasificación de imágenes con ViT

- Detección de objetos con DETR

- Segmentación semántica con SegFormer

- Segmentación panóptica con DETR

- Segmentación Universal con OneFormer (Segmentación Semántica, de Instancia y Panóptica con un solo modelo)

En Audio:

En tareas multimodales:

Escribe con Transformer, construido por el equipo de Hugging Face, es la demostración oficial de las capacidades de generación de texto de este repositorio.

Para usar inmediatamente un modelo en una entrada determinada (texto, imagen, audio, ...), proporcionamos la API de pipeline. Los pipelines agrupan un modelo previamente entrenado con el preprocesamiento que se usó durante el entrenamiento de ese modelo. Aquí se explica cómo usar rápidamente un pipeline para clasificar textos positivos frente a negativos:

>>> from transformers import pipeline

# Allocate a pipeline for sentiment-analysis

>>> classifier = pipeline('sentiment-analysis')

>>> classifier('We are very happy to introduce pipeline to the transformers repository.')

[{'label': 'POSITIVE', 'score': 0.9996980428695679}]La segunda línea de código descarga y almacena en caché el modelo previamente entrenado que usa la canalización, mientras que la tercera lo evalúa en el texto dado. Aquí la respuesta es "positiva" con una confianza del 99,97%.

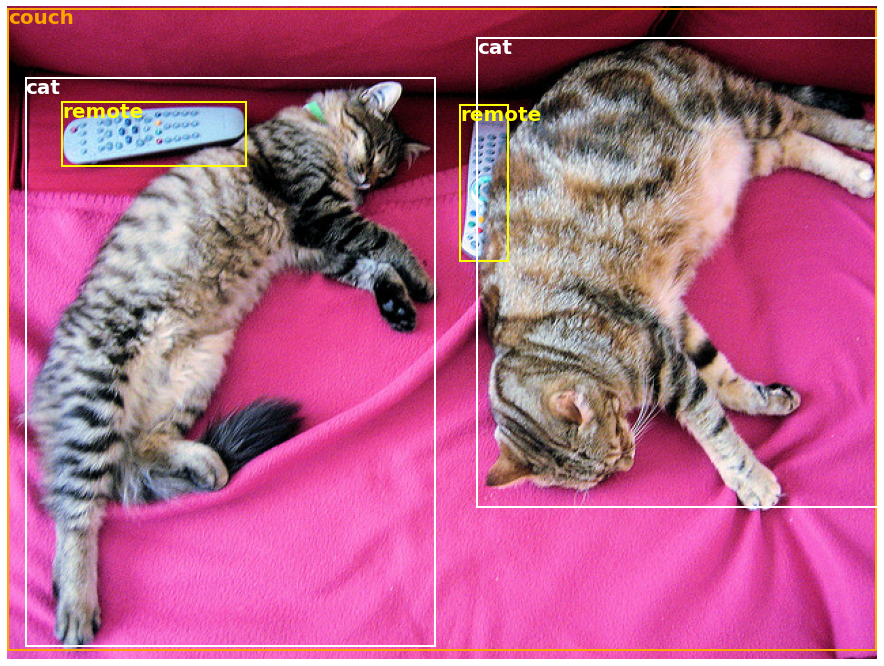

Muchas tareas tienen un pipeline preentrenado listo para funcionar, en NLP pero también en visión por ordenador y habla. Por ejemplo, podemos extraer fácilmente los objetos detectados en una imagen:

>>> import requests

>>> from PIL import Image

>>> from transformers import pipeline

# Download an image with cute cats

>>> url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/coco_sample.png"

>>> image_data = requests.get(url, stream=True).raw

>>> image = Image.open(image_data)

# Allocate a pipeline for object detection

>>> object_detector = pipeline('object_detection')

>>> object_detector(image)

[{'score': 0.9982201457023621,

'label': 'remote',

'box': {'xmin': 40, 'ymin': 70, 'xmax': 175, 'ymax': 117}},

{'score': 0.9960021376609802,

'label': 'remote',

'box': {'xmin': 333, 'ymin': 72, 'xmax': 368, 'ymax': 187}},

{'score': 0.9954745173454285,

'label': 'couch',

'box': {'xmin': 0, 'ymin': 1, 'xmax': 639, 'ymax': 473}},

{'score': 0.9988006353378296,

'label': 'cat',

'box': {'xmin': 13, 'ymin': 52, 'xmax': 314, 'ymax': 470}},

{'score': 0.9986783862113953,

'label': 'cat',

'box': {'xmin': 345, 'ymin': 23, 'xmax': 640, 'ymax': 368}}]Aquí obtenemos una lista de objetos detectados en la imagen, con un cuadro que rodea el objeto y una puntuación de confianza. Aquí está la imagen original a la derecha, con las predicciones mostradas a la izquierda:

Puedes obtener más información sobre las tareas admitidas por la API de pipeline en este tutorial.

Además de pipeline, para descargar y usar cualquiera de los modelos previamente entrenados en su tarea dada, todo lo que necesita son tres líneas de código. Aquí está la versión de PyTorch:

>>> from transformers import AutoTokenizer, AutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

>>> model = AutoModel.from_pretrained("google-bert/bert-base-uncased")

>>> inputs = tokenizer("Hello world!", return_tensors="pt")

>>> outputs = model(**inputs)Y aquí está el código equivalente para TensorFlow:

>>> from transformers import AutoTokenizer, TFAutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

>>> model = TFAutoModel.from_pretrained("google-bert/bert-base-uncased")

>>> inputs = tokenizer("Hello world!", return_tensors="tf")

>>> outputs = model(**inputs)El tokenizador es responsable de todo el preprocesamiento que espera el modelo preentrenado y se puede llamar directamente en una sola cadena (como en los ejemplos anteriores) o en una lista. Este dará como resultado un diccionario que puedes usar en el código descendente o simplemente pasarlo directamente a su modelo usando el operador de desempaquetado de argumento **.

El modelo en si es un Pytorch nn.Module normal o un TensorFlow tf.keras.Model (dependiendo De tu backend) que puedes usar de forma habitual. Este tutorial explica cómo integrar un modelo de este tipo en un ciclo de entrenamiento PyTorch o TensorFlow clásico, o como usar nuestra API Trainer para ajustar rápidamente un nuevo conjunto de datos.

-

Modelos de última generación fáciles de usar:

- Alto rendimiento en comprensión y generación de lenguaje natural, visión artificial y tareas de audio.

- Baja barrera de entrada para educadores y profesionales.

- Pocas abstracciones de cara al usuario con solo tres clases para aprender.

- Una API unificada para usar todos nuestros modelos preentrenados.

-

Menores costes de cómputo, menor huella de carbono:

- Los investigadores pueden compartir modelos entrenados en lugar de siempre volver a entrenar.

- Los profesionales pueden reducir el tiempo de cómputo y los costos de producción.

- Docenas de arquitecturas con más de 60 000 modelos preentrenados en todas las modalidades.

-

Elija el marco adecuado para cada parte de la vida útil de un modelo:

- Entrene modelos de última generación en 3 líneas de código.

- Mueva un solo modelo entre los marcos TF2.0/PyTorch/JAX a voluntad.

- Elija sin problemas el marco adecuado para la formación, la evaluación y la producción.

-

Personalice fácilmente un modelo o un ejemplo según sus necesidades:

- Proporcionamos ejemplos de cada arquitectura para reproducir los resultados publicados por sus autores originales..

- Los internos del modelo están expuestos lo más consistentemente posible..

- Los archivos modelo se pueden usar independientemente de la biblioteca para experimentos rápidos.

- Esta biblioteca no es una caja de herramientas modular de bloques de construcción para redes neuronales. El código en los archivos del modelo no se refactoriza con abstracciones adicionales a propósito, de modo que los investigadores puedan iterar rápidamente en cada uno de los modelos sin sumergirse en abstracciones/archivos adicionales.

- La API de entrenamiento no está diseñada para funcionar en ningún modelo, pero está optimizada para funcionar con los modelos proporcionados por la biblioteca. Para bucles genéricos de aprendizaje automático, debe usar otra biblioteca (posiblemente, Accelerate).

- Si bien nos esforzamos por presentar tantos casos de uso como sea posible, los scripts en nuestra carpeta de ejemplos son solo eso: ejemplos. Se espera que no funcionen de forma inmediata en su problema específico y que deba cambiar algunas líneas de código para adaptarlas a sus necesidades.

Este repositorio está probado en Python 3.8+, Flax 0.4.1+, PyTorch 1.11+ y TensorFlow 2.6+.

Deberías instalar 🤗 Transformers en un entorno virtual. Si no estas familiarizado con los entornos virtuales de Python, consulta la guía de usuario.

Primero, crea un entorno virtual con la versión de Python que vas a usar y actívalo.

Luego, deberás instalar al menos uno entre Flax, PyTorch o TensorFlow. Por favor, ve a la página de instalación de TensorFlow, página de instalación de PyTorch y/o las páginas de instalación de Flax y Jax con respecto al comando de instalación específico para tu plataforma.

Cuando se ha instalado uno de esos backends, los 🤗 Transformers se pueden instalar usando pip de la siguiente manera:

pip install transformersSi deseas jugar con los ejemplos o necesitas la última versión del código y no puedes esperar a una nueva versión, tienes que instalar la librería de la fuente.

🤗 Transformers se puede instalar usando conda de la siguiente manera:

conda install conda-forge::transformersNOTA: Instalar

transformersdesde el canalhuggingfaceestá obsoleto.

Sigue las páginas de instalación de Flax, PyTorch o TensorFlow para ver cómo instalarlos con conda.

NOTA: En Windows, es posible que se le pida que active el modo de desarrollador para beneficiarse del almacenamiento en caché. Si esta no es una opción para usted, háganoslo saber en esta issue.

Todos los puntos de control del modelo aportados por 🤗 Transformers están perfectamente integrados desde huggingface.co Centro de modelos donde son subidos directamente por los usuarios y organizaciones.

Número actual de puntos de control:

🤗 Transformers actualmente proporciona las siguientes arquitecturas: ver aquí para un resumen de alto nivel de cada uno de ellas.

Para comprobar si cada modelo tiene una implementación en Flax, PyTorch o TensorFlow, o tiene un tokenizador asociado respaldado por la librería 🤗 Tokenizers, ve a esta tabla.

Estas implementaciones se han probado en varios conjuntos de datos (consulte los scripts de ejemplo) y deberían coincidir con el rendimiento de las implementaciones originales. Puede encontrar más detalles sobre el rendimiento en la sección Examples de la documentación.

| Sección | Descripción |

|---|---|

| Documentación | Toda la documentación de la API y tutoriales |

| Resumen de tareas | Tareas soportadas 🤗 Transformers |

| Tutorial de preprocesamiento | Usando la clase Tokenizer para preparar datos para los modelos |

| Entrenamiento y puesta a punto | Usando los modelos aportados por 🤗 Transformers en un bucle de entreno de PyTorch/TensorFlow y la API de Trainer |

| Recorrido rápido: secuencias de comandos de ajuste/uso | Scripts de ejemplo para ajustar modelos en una amplia gama de tareas |

| Compartir y subir modelos | Carga y comparte tus modelos perfeccionados con la comunidad |

| Migración | Migra a 🤗 Transformers desde pytorch-transformers o pytorch-pretrained-bert |

Ahora nosotros tenemos un paper que puedes citar para la librería de 🤗 Transformers:

@inproceedings{wolf-etal-2020-transformers,

title = "Transformers: State-of-the-Art Natural Language Processing",

author = "Thomas Wolf and Lysandre Debut and Victor Sanh and Julien Chaumond and Clement Delangue and Anthony Moi and Pierric Cistac and Tim Rault and Rémi Louf and Morgan Funtowicz and Joe Davison and Sam Shleifer and Patrick von Platen and Clara Ma and Yacine Jernite and Julien Plu and Canwen Xu and Teven Le Scao and Sylvain Gugger and Mariama Drame and Quentin Lhoest and Alexander M. Rush",

booktitle = "Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations",

month = oct,

year = "2020",

address = "Online",

publisher = "Association for Computational Linguistics",

url = "https://www.aclweb.org/anthology/2020.emnlp-demos.6",

pages = "38--45"

}